반응형

Bagging 이란?

. Bagging

1) Bagging 은 통계학습방법의 분산을 줄이기 위해 고안된 방법이고 의사결정나무에 사용될 경우 매우 유용

2) 서로 독립이고 분산이 σ^2인 n의 관측치 Z ̅의 분산은 σ^2/n

3) 즉 표본 평균은 분산을 줄인다. 물론 훈련 자료가 여러개 있는 경우는 실제로 드뭄

4) Bootstrap을 사용한다면 하나의 훈련자료에서 여러 개의 샘플을 만들 수 있음

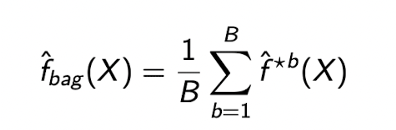

5) 먼저 B개의 bootstrap 훈련자료를 생성하고 각각의 훈련자료에서 예측값을 구한 후 그 평균을 이용하여 최종 예측값을 구한다.

Bagging Ensemble Algorithm 이란?

1) 여러 결정 나무 모형들로 구성된 앙상블

2) Bagging = Bootstrap Aggregation

3) Bootstrap sample: 데이터 셋으로 부터 중복을 허용하여 추출한 표본

4) 분류 문제(classification): 예측값으로 majority vote

5) 회귀문제(regression): 예측값의 평균

6) Bagging Decision Tree 효율성

• (bootstrap으로 얻은) 서로 다른 훈련 데이터셋 이용

• 이로 인해 모델 간 예측값에 차이발생. 즉. Correlation 감소

=> Ensemble diversity(다양성) 근간

Bagging Ensemble Algorithm 설명

1) Unpruned decision tree(가지치기를 하지 않은 상태의 의사 결정 트리) 주로 사용

2) 약간의 과적합이 발생하며 variance가 높음(= 데이터에 따라 예측 성능이 크게 달라짐)

3) Variance가 높은 다른 머신러닝 알고리즘도 배깅에 사용 가능(KNN 등) 그러나 decision tree가 가장 효과적으로 알려짐

4) 상대적으로 작은 크기의 데이터셋에 잘 맞음

5) 데이터셋의 크기 ↓ => 트리의 variance ↑ => 앙상블 성능 ↑

6) 이미 성능이 좋고 분산이 낮은 모델을 이용하면 앙상블 성능이 오히려 낮아질 수도 있음

반응형

'머신러닝' 카테고리의 다른 글

| [머신러닝] 앙상블(Ensemble) 기법_부스팅(Boosting)_GBM (1) | 2024.01.12 |

|---|---|

| [머신러닝] 앙상블(Ensemble) 기법_부스팅(Boosting)_Adaboost (1) | 2024.01.12 |

| [머신러닝] 앙상블(Ensemble) 기법_부스팅(Boosting)_개념 정리 (0) | 2024.01.12 |

| [머신러닝] 앙상블(Ensemble) 기법_배깅(Bagging)_Random Forest Algorithm (1) | 2024.01.12 |

| [머신러닝] 앙상블(Ensemble) 기법_배깅(Bagging)_개념 정리(2) (0) | 2024.01.12 |